Мы готовы помочь Вам

Hardw/AI: Почему 192 ГБ VRAM — это новый «санитарный минимум» для инференса

К концу 2025 года индустрия прошла точку перегиба: CAPEX на эксплуатацию моделей (Inference) впервые превысил затраты на их обучение. Однако внедрение моделей класса Dense 400B+ (например, Llama 3.1 405B) в коммерческий сектор столкнулось с суровой физикой: стандартные для эпохи H100 80 ГБ памяти стали «бутылочным горлышком», убивающим экономику проекта.

Ниже — разбор того, почему память стала важнее флопсов, и честный взгляд на спецификации B200 и MI325X без маркетинговых приукрашиваний.

Анатомия «узкого места» (Memory Wall)

В инференсе LLM мы боремся за две метрики: Time To First Token (TTFT) (задержка до первого символа) и Inter-Token Latency (ITL) (скорость потоковой генерации).

Главное правило архитектора: горячие данные (Weights + KV Cache) обязаны жить в HBM.

Если модель не влезает в VRAM и начинается CPU Offloading, происходит катастрофа:

- Пропасть в пропускной способности: Мы падаем с шины HBM3e (~8 ТБ/с) на шину DDR5 (~400–800 ГБ/с на сокет). Разница в 10–20 раз.

- Коллапс генерации: Скорость падает с 100+ токенов/сек до 2-3 токенов/сек. Это неприемлемо для интерактивных чат-ботов, копайлотов или RAG-систем реального времени.

KV Cache: Скрытый пожиратель памяти

Многие забывают, что спецификация весов модели (например, ~810 ГБ для 405B в FP16) — это только половина беды. Вторая половина — Context Window.

При контексте 128k токенов и размере батча (Batch Size) 64, KV-кэш может занимать сотни гигабайт.

- Реальность: Даже при агрессивном квантовании KV-кэша (FP8), на длинных контекстах он начинает вытеснять веса модели.

- Следствие: Вам нужно не просто «вместить модель», вам нужен запас (headroom) в 30-40% памяти именно под динамический кэш пользовательских сессий.

Битва спецификаций: B200 vs MI325X (Факт-чек)

Рынок ответил выпуском чипов с повышенной плотностью памяти. Однако здесь важно отделять реальные даташиты от слайдов с презентаций.

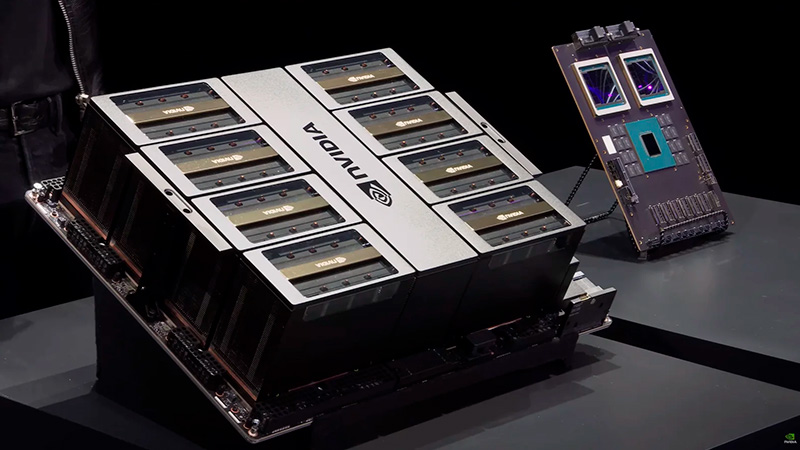

1. Nvidia B200 (Blackwell)

Маркетинг заявляет 192 ГБ HBM3e.

Инженерная реальность: Физически на чипе действительно 192 ГБ (8 стеков по 24 ГБ). Однако в серийных продуктах (HGX/DGX) пользователю часто доступно 180 ГБ. Оставшиеся 12 ГБ зарезервированы под ECC и повышение выхода годных чипов (yield rates).

- Вердикт: Это отличный буст после 80 ГБ у H100, но для моделей 400B+ на одном узле (8x GPU) всё еще потребуется тщательное планирование шардинга.

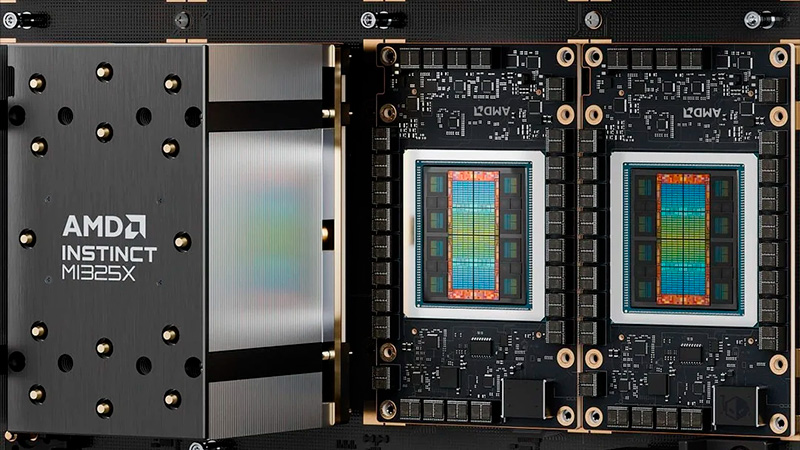

2. AMD Instinct MI325X

В сети часто гуляет ошибочная цифра 288 ГБ.

Инженерная реальность: MI325X (актуальный флагман конца 2025) оснащен 256 ГБ HBM3e. Цифра 288 ГБ относится к следующему поколению (архитектура CDNA 4), которое пока не доступно в коммерческих отгрузках.

- Вердикт: Даже с 256 ГБ AMD выигрывает по показателю Memory per GPU. Это позволяет размещать Llama 3.1 70B целиком на одной карте с огромным запасом под контекст, либо 405B на 4 картах вместо 8.

| Характеристика | Nvidia B200 | AMD Instinct MI325X |

|---|---|---|

| Память (Usable) | ~180 GB HBM3e | 256 GB HBM3e |

| ПСП (Bandwidth) | ~8 TB/s | ~6 TB/s |

| Сценарий использования | Максимальная производительность (FP4/FP8), проприетарный стек CUDA. | Максимальная емкость (RAG, Long Context), открытый стек ROCm. |

Тренды 2026: Борьба с Inter-GPU Link

Почему мы так бьемся за объем памяти на одном чипе?

Чтобы запустить модель уровня GPT-4/5, мы используем Tensor Parallelism, «разрезая» слои модели между 8 или 16 GPU.

Проблема в том, что передача данных между картами (даже по NVLink 5-го поколения) добавляет латентность. Чем меньше карт нужно для удержания модели, тем быстрее инференс и ниже стоимость владения (TCO). В 2026 году победит не тот, у кого больше FLOPS, а тот, кто позволит запустить «толстую» модель на минимальном количестве кремния.

Вывод от HYPERPC

Мы в HYPERPC видим прямой запрос от бизнеса на переход от «обучения любой ценой» к эффективному инференсу. Гонка за параметрами моделей сменилась гонкой за VRAM.

Для наших корпоративных клиентов, разворачивающих локальные LLM (On-premise), мы рекомендуем следующую стратегию:

- Не экономить на VRAM: Если ваша задача — RAG с большими документами, выбирайте карты с максимальным объемом памяти. Дефицит памяти невозможно компенсировать мощностью CPU.

- Баланс экосистемы: Nvidia B200 остается стандартом для сложных пайплайнов благодаря CUDA, но решения на базе AMD с их 256 ГБ памяти становятся крайне привлекательными для специфических задач с длинным контекстом.

- Готовые платформы: Самостоятельная сборка кластеров под такие нагрузки чревата проблемами с охлаждением и питанием. Наши серверные решения HYPERPC AI & HPC проектируются с учетом термопакетов в 700Вт+ на чип, обеспечивая стабильную работу 24/7 без троттлинга.

Инвестируйте в память сегодня, чтобы не переплачивать за простой серверов завтра.

Источники и техническая документация

При подготовке материала использовались данные из официальных спецификаций и технических блогов:

- Nvidia Blackwell Architecture Technical Brief Nvidia Technical Blog / Datasheets — Детали архитектуры B200, спецификации памяти и NVLink.

- AMD Instinct MI325X Specifications AMD Official Website - Instinct Accelerators — Подтверждение объема 256 ГБ и типа памяти HBM3e

- Meta Llama 3.1 Hardware Requirements Meta AI Engineering Blog — Данные о требованиях к памяти для моделей 405B (FP16/FP8).